OpenClaw (구 Clawdbot)에 최적화된 가성비 LLM: Zhipu AI GLM-4.7 모델 분석 및 연동 가이드

1. 서론: 지능형 에이전트의 대중화와 비용의 상관관계

2026년 초, OpenClaw(구 Clawdbot) 프레임워크의 등장은 개인용 워크스테이션 운영 방식에 근본적인 변화를 가져왔습니다. 사용자의 명령을 단순 해석하는 단계를 넘어, 시스템 레벨에서 자율적으로 작업을 수행하는 ‘에이전틱 게이트웨이’ 기술이 성숙 단계에 접어든 것입니다.

그러나 이러한 자율형 에이전트의 상시 가동은 필연적으로 막대한 API 호출 비용을 발생시킵니다. 에이전트가 특정 목표를 달성하기 위해 내부적으로 수십 번의 ‘생각(Reasoning)’과 ‘실행(Execution)’ 루프를 반복하기 때문입니다. 따라서 2026년 현재, 에이전트 구축의 성패는 고성능과 저비용을 동시에 만족하는 최적의 모델 선택에 달려 있다고 해도 과언이 아닙니다.

2. OpenClaw의 ‘롭스터(Lobster)’ 아키텍처와 운영 메커니즘

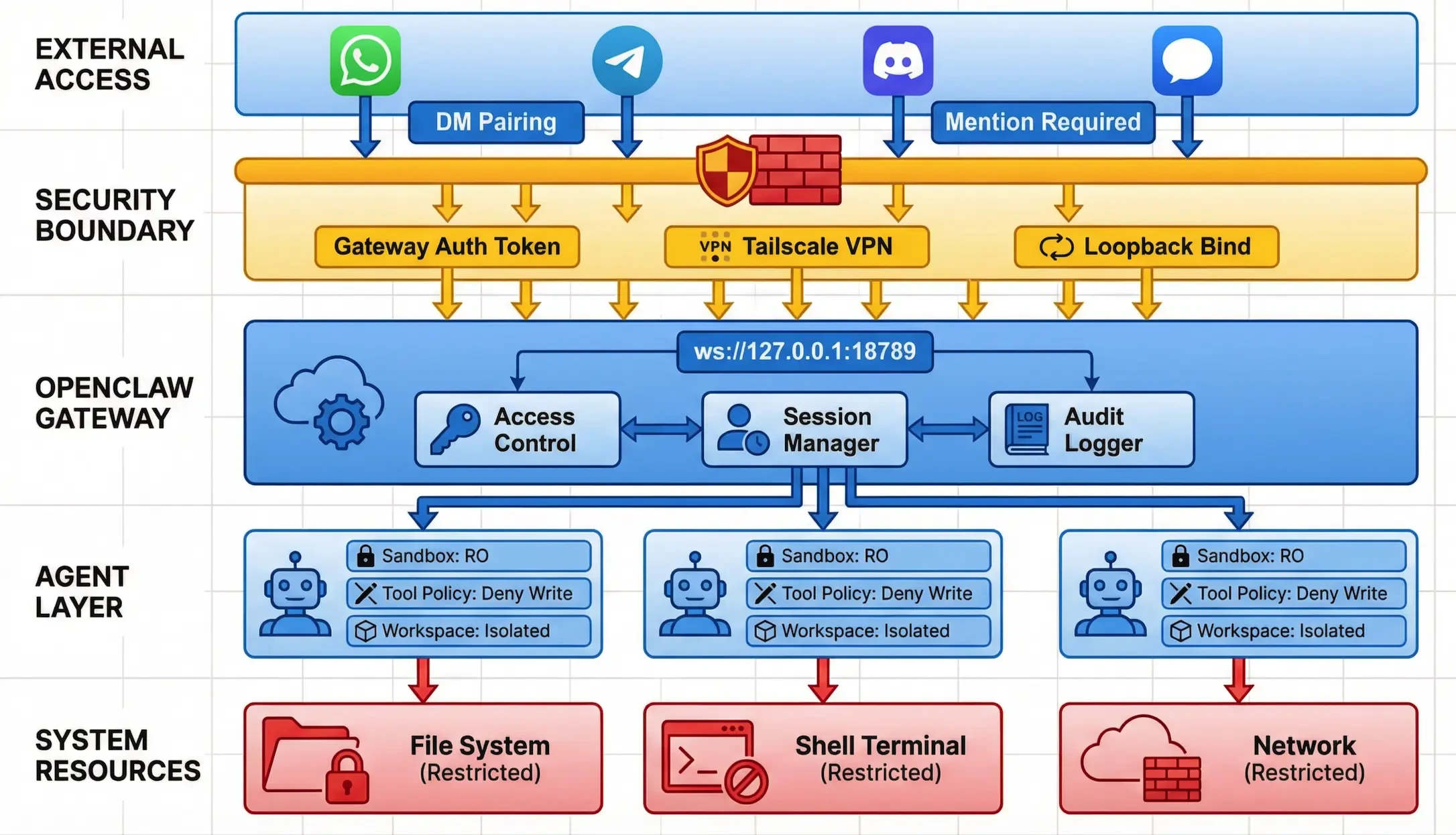

OpenClaw는 5개의 핵심 레이어로 구성된 ‘롭스터(Lobster)’ 아키텍처를 기반으로 작동합니다. 이 시스템은 텔레그램이나 슬랙과 같은 인터페이스를 통해 사용자의 의도를 수신하고, 이를 LLM(브레인)으로 전달하여 실행 가능한 쉘 명령어나 파이썬 스크립트로 변환합니다.

OpenClaw 핵심 구성 요소

| 구성 요소 | 주요 기능 | 기술적 구현 특징 | | :— | :— | :— | | 게이트웨이 | 메시징 플랫폼 인터페이스 | WebSocket 기반, 비동기 통신 지원 | | 브레인 (LLM) | 논리 추론 및 의사결정 | API 기반의 지능 엔진 (GLM, Claude 등) | | 샌드박스 | 격리된 실행 환경 | Docker 컨테이너 기반 보안 아키텍처 | | 스킬 레지스트리 | 확장 기능 도구 모음 | MCP(Model Context Protocol) 표준 준수 | | 메모리 | 문맥 및 지식 저장소 | 계층적 벡터 데이터베이스 연동 가능 |

이 구조에서 가장 비용이 많이 발생하는 구간은 ‘브레인’ 레이어입니다. 에이전트가 자율적으로 판단을 내릴 때마다 발생하는 토큰 소모량을 감당하기 위해, 우리는 가장 경제적인 대안을 모색해야 합니다.

3. 2026년 주요 모델별 API 가격 및 효율성 비교

현재 시장에서 가용한 주요 모델들의 비용 구조를 분석해 보면, Zhipu AI의 GLM 시리즈가 제공하는 경제적 이점이 확연히 드러납니다.

LLM API 가격 비교 표 (단위: 100만 토큰당 USD, 2026년 기준)

| 모델 등급 | 모델명 | 입력(Input) | 출력(Output) | 가성비 지수(Eff) | | :— | :— | :—: | :—: | :—: | | 최고급 | Claude 4.5 Opus | $15.00 | $75.00 | 낮음 | | 표준급 | GPT-5.2 Pro | $2.50 | $10.00 | 보통 | | 경제급 | Gemini 3 Flash | $0.10 | $0.40 | 높음 | | 전략급 | Zhipu GLM-4.7 | $0.07 | $0.35 | 매우 높음 |

비교 분석 결과, GLM-4.7은 Claude Opus급의 추론 능력(SWE-bench 점수 73.8% 기록)을 갖추었음에도 불구하고, 가격은 최고급 모델의 약 1/200 수준에 불과합니다. 이는 상시 가동되어야 하는 자율형 에이전트에게 있어 가장 이상적인 ‘가성비’ 모델임을 입증합니다.

4. 왜 GLM-4.7인가: 에이전트 전용 모델로서의 가치

GLM-4.7을 추천하는 이유는 단순한 가격 때문만이 아닙니다. 자율형 에이전트 환경에서 이 모델은 다음과 같은 세 가지 핵심 강점을 보유하고 있습니다.

- 에이전틱 코딩 최적화: GLM-4.7은 시스템 명령어 생성 및 파이썬 스크립트 작성에서 글로벌 모델들과 대등한 성능을 보입니다. 특히 다국어 지원 능력이 뛰어나 한국어 명령을 정확히 이해하고 로컬 시스템 명령어로 치환하는 능력이 탁월합니다.

- 낮은 지연 시간(Latency): OpenClaw와 같은 실시간 상호작용 시스템에서 응답 속도는 사용자 경험을 좌우합니다. GLM-4.7은 대규모 트래픽 처리에서도 안정적인 Latency를 유지합니다.

- 유연한 통합성: OpenAI와 호환되는 API 엔드포인트를 제공하므로, 기존 OpenClaw의 설정을 최소한으로 변경하여 즉시 적용할 수 있습니다.

5. OpenClaw에서 GLM-4.7 설정 및 연동 가이드

OpenClaw 프레임워크에서 GLM-4.7을 연동하는 방법은 매우 직관적입니다. 설정 파일(.env) 또는 환경 변수를 통해 다음과 같이 구성을 변경할 수 있습니다.

단계별 설정 방법

- API 키 발급: Zhipu AI 오픈 플랫폼(BigModel.ai)에서 API 키를 발급받습니다.

- 환경 변수 수정: OpenClaw 설치 폴더의

.env파일을 열어 아래 항목을 수정합니다. - 모델 지정:

BRAIN_MODEL변수를glm-4.7로 설정합니다.

1

2

3

4

5

6

# OpenClaw GLM-4.7 Integration Settings

LLM_PROVIDER="openai" # OpenAI 호환 라이브러리 사용

OPENAI_API_KEY="your_zhipu_api_key_here"

OPENAI_BASE_URL="https://open.bigmodel.ai/api/paas/v4/"

BRAIN_MODEL="glm-4.7"

MAX_TOKENS=4096

이 설정을 마친 후 OpenClaw 게이트웨이를 재시작하면, 에이전트는 이제 가장 경제적인 GLM-4.7 모델을 브레인으로 사용하여 작업을 수행하기 시작합니다.

6. 보안 및 거버넌스: 안전한 자율성 확보

경제적인 모델을 사용하더라도 시스템 접근 권한을 가진 에이전트의 보안 설정은 타협의 대상이 될 수 없습니다. GLM-4.7 기반 에이전트 운영 시 다음의 안전 수칙을 반드시 병행하십시오.

- Docker 기반 실행: 모든 실행 루프는 호스트와 격리된 샌드박스 내에서 이루어져야 합니다.

- 실행 승인 활성화:

exec.ask: "on"설정을 통해 중요 명령어는 반드시 사용자의 텔레그램 승인을 거치도록 합니다. - API 사용량 제한: 예기치 못한 무한 루프 발생으로 인한 비용 폭증을 막기 위해 Zhipu AI 대시보드에서 일일 할당량(Quota)을 설정하십시오.

7. 결론: 경제적 자율 주행의 시대

Zhipu AI의 GLM-4.7과 OpenClaw의 결합은 고성능 자율형 AI 에이전트를 누구나 저렴한 비용으로 소유할 수 있는 길을 열어주었습니다. 2026년의 지식 노동자들은 더 이상 API 비용을 걱정하며 기술 도입을 주저할 필요가 없습니다. 본고에서 제시한 모델 믹싱 전략과 보안 가이드를 바탕으로, 여러분만의 안전하고 효율적인 ‘24/7 AI 비서’를 구축해 보시기 바랍니다.

참고 자료 (References)

- OpenClaw 공식 아키텍처 가이드 (2026)

- Zhipu AI (BigModel) GLM-4.7 성능 백서 (2026.Q1)

- 2026년 글로벌 LLM API 가격 벤치마크 보고서

- 자율형 에이전트 보안 취약점 사례 연구 (CVE-2026-시리즈)